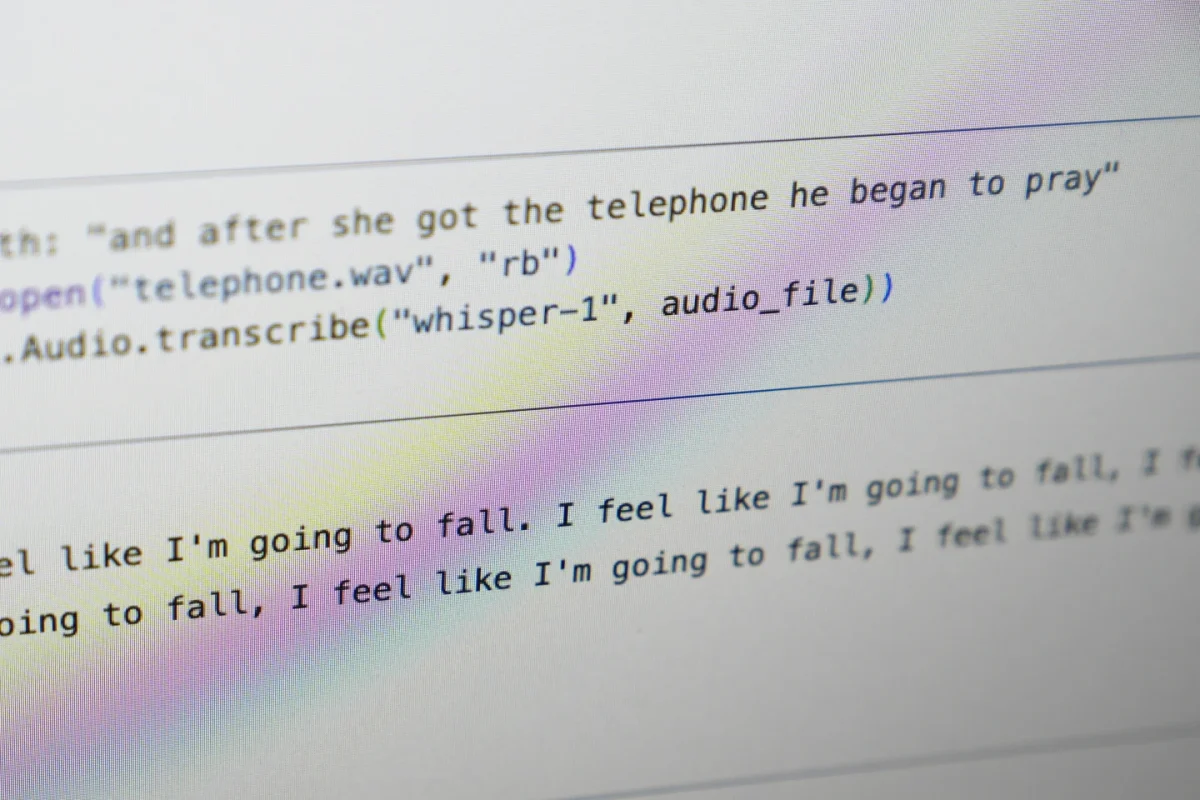

O Whisper, ferramenta de transcrição de áudio por IA da OpenAI, tem sido amplamente adotado em diversos setores, incluindo o de saúde, mas vem apresentando sérias falhas. Segundo a Associated Press (AP), a ferramenta comete “alucinações”, criando frases inexistentes em transcrições – um risco significativo em ambientes médicos, onde esses erros podem impactar diagnósticos e tratamentos. Especialistas pedem cautela ao integrar a IA em contextos sensíveis, destacando a urgência de regulamentação e maior controle.

Leia Também

Dola IA e WhatsApp: Inteligência artificial que organiza a sua agenda

Conheça a Dola IA, assistente virtual de calendário com inteligência artificial

Alucinações em Transcrições e Riscos Associados

O termo “alucinação” se refere a partes do texto que o sistema gera sem correspondência com o áudio real, incluindo até referências a tratamentos inexistentes. Segundo a AP, especialistas identificaram frases inventadas em cerca de 40% das transcrições revisadas, o que levanta sérias preocupações sobre a precisão da ferramenta. Esses erros podem incluir termos médicos fictícios e, em alguns casos, até mesmo comentários raciais ou de cunho violento.

Uso em Ambientes de Alto Risco e Segurança do Paciente

A OpenAI recomenda cautela no uso de Whisper em setores de alto risco, como o de saúde. No entanto, alguns hospitais já o utilizam para transcrever consultas com pacientes, como em clínicas e hospitais dos EUA. A ferramenta é usada para agilizar processos, liberando médicos de tarefas manuais, mas os riscos se tornam elevados quando essas transcrições não são verificadas. O fato de algumas ferramentas baseadas em Whisper apagarem os áudios originais por “motivos de segurança” pode agravar o problema, impedindo que médicos revisem o conteúdo.

Leia Também

Dola IA: Dicas avançadas de assistente pessoal por WhatsApp

Preocupações com Privacidade e Compartilhamento de Dados

Além das alucinações, a AP destaca que o uso de ferramentas como Whisper em consultas médicas levanta questões sobre privacidade. Em uma situação citada, uma paciente recusou compartilhar o áudio de sua consulta com terceiros, incluindo provedores de tecnologia, devido ao receio de exposição de informações pessoais. A coleta e armazenamento de dados em plataformas como a Microsoft Azure, que opera com a OpenAI, acrescentam uma camada de preocupação para pacientes e reguladores.

Conclusão: A Urgência de Regulação e Responsabilidade

Com o avanço de ferramentas de IA, a AP destaca o pedido de especialistas para uma regulamentação mais rigorosa sobre a integração de IA em contextos de saúde. A possibilidade de “alucinações” em transcrições médicas e o compartilhamento de dados sem consentimento direto exigem que essas tecnologias sejam tratadas com responsabilidade. A OpenAI afirma que está trabalhando para reduzir essas falhas, mas a questão permanece: é seguro implementar essa tecnologia em contextos tão sensíveis?

Para mais informações, consulte o artigo completo da Associated Press aqui.

🤝 Participe da Comunidade Papo de Dev no WhatsApp

Quer continuar a conversa, tirar dúvidas ou trocar experiências com quem vive o universo tech no dia a dia?

🚀 Junte-se à nossa comunidade no WhatsApp e conecte-se com devs iniciantes e experientes de todo o Brasil. É gratuito, colaborativo e feito pra quem quer aprender e evoluir junto!