O Google Research anunciou o VaultGemma, seu primeiro modelo de linguagem de grande porte (LLM) projetado para preservar a privacidade dos dados usados em seu treinamento. A novidade representa um marco no desenvolvimento de IA, já que busca responder a uma das maiores críticas sobre o setor: o risco de memorização de dados sensíveis por parte dos modelos.

Segundo a pesquisa publicada pelo Google, modelos de IA podem, em alguns casos, reproduzir informações específicas contidas nos dados de treinamento — o que inclui desde conteúdos com direitos autorais até dados pessoais de usuários. Para enfrentar esse problema, a empresa aplicou differential privacy, uma técnica que introduz “ruído” durante o processo de treinamento para impedir que dados individuais sejam memorizados e reapareçam nas respostas.

Como funciona o VaultGemma

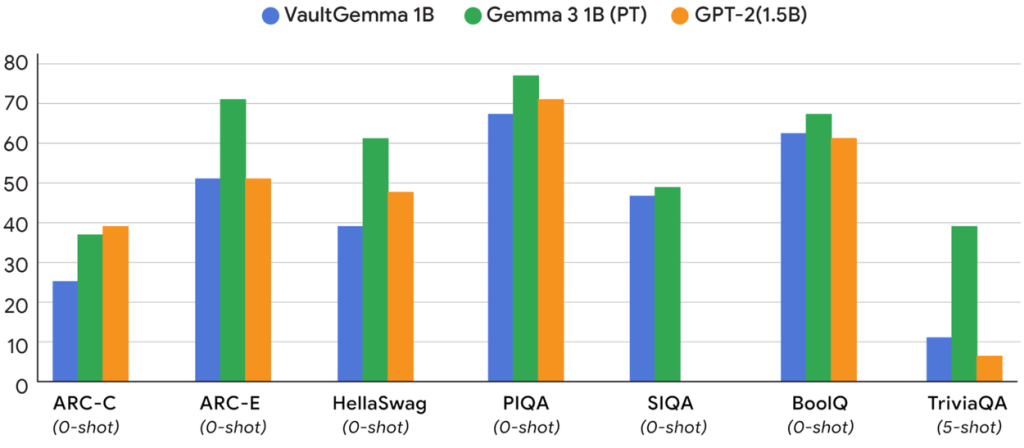

O VaultGemma é baseado no Gemma 2, modelo de código aberto lançado anteriormente pelo Google, mas com ajustes para aplicar privacidade diferencial. Apesar de ter apenas 1 bilhão de parâmetros, o que é considerado pequeno em comparação a outros LLMs, o modelo mostrou desempenho equivalente a sistemas não privados do mesmo porte.

O estudo do Google também apresentou as primeiras “leis de escala” da privacidade diferencial em modelos de IA. Os pesquisadores identificaram que, quanto maior a quantidade de ruído adicionada, maior o impacto negativo na qualidade das respostas. Porém, esse efeito pode ser compensado com mais capacidade computacional (FLOPs) ou dados de treinamento (tokens).

Por que isso importa

A aplicação da privacidade diferencial em modelos de IA não é apenas um avanço técnico, mas também um movimento estratégico. Com a crescente pressão de órgãos reguladores na Europa, nos Estados Unidos e também no Brasil — impulsionada pela LGPD (Lei Geral de Proteção de Dados) —, as empresas de tecnologia precisam demonstrar que estão comprometidas em proteger a privacidade dos usuários.

Além disso, a pesquisa sugere que essa abordagem funciona melhor em modelos menores e especializados, como assistentes virtuais ou sistemas de recomendação, que não necessitam da escala massiva dos modelos de uso geral.

Leia Também:

Trabalho extra na área de tecnologia: como equilibrar o freela com qualidade de vida

Uso de IA por Desenvolvedores: riscos, vantagens e o equilíbrio necessário

Por que sistemas legados estão quebrando times de TI ?

Disponibilidade do VaultGemma

O VaultGemma já está disponível para desenvolvedores no Hugging Face e no Kaggle, com pesos abertos (open weights), mas não totalmente open source. O Google permite modificações e redistribuição, desde que não haja usos maliciosos e que a licença da família Gemma seja mantida.

O futuro da privacidade em IA

O lançamento do VaultGemma sinaliza uma nova direção para o Google, que busca equilibrar desempenho e privacidade em seus sistemas de IA. Embora a técnica ainda traga desafios em termos de precisão e custos de treinamento, ela pode se tornar um padrão para modelos menores, voltados a aplicações específicas, ajudando a construir uma relação mais transparente e segura com os usuários.

📌 Fonte: Ars Technica

🤝 Participe da Comunidade Papo de Dev no WhatsApp

Quer continuar a conversa, tirar dúvidas ou trocar experiências com quem vive o universo tech no dia a dia?

🚀 Junte-se à nossa comunidade no WhatsApp e conecte-se com devs iniciantes e experientes de todo o Brasil. É gratuito, colaborativo e feito pra quem quer aprender e evoluir junto!